L’Unione europea ha la sua legge sull’intelligenza artificiale

Il 13 marzo il Parlamento europeo ha approvato l’AI Act, il regolamento europeo sull’intelligenza artificiale, e a maggio è arrivata anche l’approvazione definitiva del Consiglio dell’Unione Europea. In estrema sintesi e lasciando a margine vari dettagli ecco quello che c’è da sapere.

Le sue disposizioni inizieranno a entrare in vigore per gradi:

- 6 mesi dopo: i Paesi saranno tenuti a proibire i sistemi di AI vietati;

- 1 anno dopo: inizieranno ad applicarsi le regole per i sistemi di intelligenza artificiale di uso generale;

- 2 anni dopo: il resto della legge sull’AI sarà applicabile;

- 36 mesi dopo: gli obblighi per i sistemi ad alto rischio.

Le sanzioni in caso di non conformità possono arrivare fino a 35 milioni di euro o al 7% del fatturato annuo mondiale.

Saranno vietate/i:

- Sfruttamento delle vulnerabilità di persone o gruppi in base all’età, alla disabilità o allo status socio-economico;

- Le pratiche manipolatorie e ingannevoli, sistemi che usino tecniche subliminali per distorcere materialmente la capacità decisionale di una persona;

- Categorizzazione biometrica ovvero la classificazione di individui sulla base di dati biometrici per dedurre informazioni sensibili come razza, opinioni politiche o orientamento sessuale (eccezioni per le attività di contrasto);

- Punteggio sociale (valutazione di individui o gruppi nel tempo in base al loro comportamento sociale o a caratteristiche personali);

- Creazione di database di riconoscimento facciale attraverso lo scraping non mirato di immagini da internet o da filmati di telecamere a circuito chiuso;

- Inferenza delle emozioni nei luoghi di lavoro e nelle istituzioni educative (eccezioni per motivi medici o di sicurezza);

- Le pratiche di valutazione del rischio di commettere un reato basate esclusivamente sulla profilazione o sulla valutazione delle caratteristiche di una persona.

Non è del tutto vietata bensì limitata l’identificazione biometrica in tempo reale in spazi accessibili al pubblico – sulla base di circostanze definite (gli usi ammessi includono, ad esempio, la ricerca di una persona scomparsa o la prevenzione di un attacco terroristico) che richiedono un’approvazione giudiziaria o di un’autorità indipendente.

L’identificazione biometrica a posteriori è considerata ad alto rischio. Per questo, per potervi fare ricorso, l’autorizzazione giudiziaria dovrà essere collegata a un reato.

Seguono gli ambiti che non sono vietati ma sono considerati “ad alto rischio” e che dunque saranno valutati prima di essere immessi sul mercato e anche durante il loro ciclo di vita e su cui i cittadini potranno presentare reclami alle autorità nazionali.

Includono non solo le infrastrutture critiche o le componenti di sicurezza ma anche la formazione scolastica (per determinare l’accesso o l’ammissione, per assegnare persone agli istituti o ai programmi di istruzione e formazione professionale a tutti i livelli, per valutare i risultati dell’apprendimento delle persone, per valutare il livello di istruzione adeguato per una persona e influenzare il livello di istruzione a cui potrà avere accesso, per monitorare e rilevare comportamenti vietati degli studenti durante le prove); la gestione dei lavoratori (per l’assunzione e la selezione delle persone, per l’adozione di decisioni riguardanti le condizioni del rapporto di lavoro, la promozione e la cessazione dei rapporti contrattuali, per l’assegnazione dei compiti sulla base dei comportamenti individuali, dei tratti o delle caratteristiche personali e per il monitoraggio o la valutazione delle persone); servizi essenziali inclusi i servizi sanitari, le prestazioni di sicurezza sociale, servizi sociali, ma anche l’affidabilità creditizia; l’amministrazione della giustizia (inclusi gli organismi di risoluzione alternativa delle controversie); la gestione della migrazione e delle frontiere (come l’esame delle domande di asilo, di visto e di permesso di soggiorno e dei relativi reclami).

I sistemi di AI per finalità generali e i modelli su cui si basano (inclusi i grandi modelli di AI generativa) dovranno rispettare una serie di requisiti di trasparenza come: divulgare che il contenuto è stato generato dall’AI; fare in modo che i modelli non generino contenuti illegali; pubblicare le sintesi dei dati protetti da copyright utilizzati per l’addestramento. I modelli più potenti, che potrebbero comportare rischi sistemici, dovranno rispettare anche altri obblighi, ad esempio quello di effettuare valutazioni dei modelli, di valutare e mitigare i rischi sistemici e di riferire in merito agli incidenti.

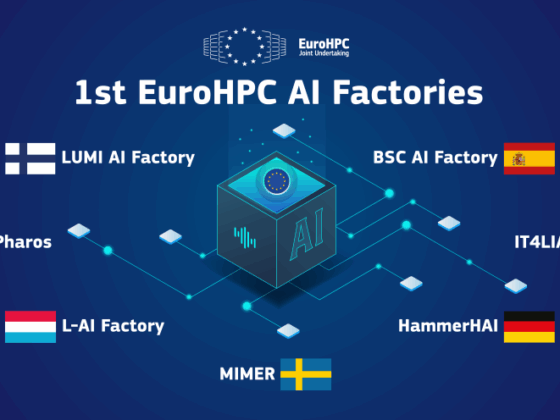

I Paesi dell’UE dovranno istituire e rendere accessibili a livello nazionale spazi di sperimentazione normativa e meccanismi di prova in condizioni reali (in inglese sandbox), in modo che PMI e start-up possano sviluppare sistemi di AI prima di immetterli sul mercato.

Tratto dalla newsletter Guerre di Rete (www.guerredirete.it).